Airflow, PostgreSQL, et MongoDB ! Comment optimiser vos flux de travail données

Pour les professionnels du domaine des données, tels que les data engineers, data scientists, et développeurs, il est crucial d'avoir accès à des outils efficaces et fiables pour gérer, stocker et analyser leurs données. Cet article vous introduit à une solution puissante et versatile composée de Airflow, PostgreSQL, et MongoDB. Nous explorerons comment ces technologies peuvent être combinées pour concevoir des pipelines de données à la fois efficaces et évolutifs. De plus, l'article met en lumière l'utilisation de fonctionnalités avancées telles que le machine learning, big data, et le modern data stack. À travers des études de cas concrets, nous illustrerons les avantages significatifs de cette synergie technologique pour des projets en ingénierie et science des données.

Comprendre les outils individuels : Airflow, PostgreSQL et MongoDB

Dans cette section, nous explorerons brièvement trois outils clés qui constituent notre stack technologique : Airflow, PostgreSQL et MongoDB. Nous aborderons ce que ces outils sont, leur utilité et leurs points forts ainsi que leurs limites.

Vous vous sentez submergé par le volume croissant de données ? Vous avez du mal à coordonner les différentes étapes de traitement des données ? Comment garantir l'efficacité et la fiabilité de vos processus de données ?

Le mot magique est ORCHESTRATION !!!

C’est quoi l’orchestration des flux de données ?

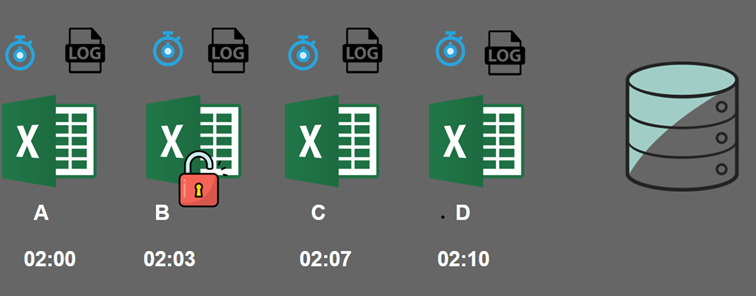

Cela commence toujours avec un fichier Excel nommé 'A', nécessitant une mise à jour. Cette opération peut être effectuée par un job Cron. Cependant, il existe également un fichier 'B', suivi d'un autre job Cron, et ce processus se répète jusqu'à atteindre le fichier 'D', chacun étant associé à un job Cron spécifique. Il est impératif que le fichier A soit chargé avant le fichier B, que le fichier B le soit avant le fichier C, et le fichier C avant le fichier D. Par la suite, une base de données est utilisée pour le stockage de ces fichiers. Dans l'éventualité où le fichier B serait verrouillé, il est crucial de vérifier si son chargement a été réalisé correctement. Chaque job dispose de ses propres journaux d'activité, qui doivent être examinés afin d'identifier toute erreur éventuelle

Si vous n'avez pas prévu de plan pour votre journée, vous devrez trouver l'erreur et relancer les jobs échoués. Attention à ne pas créer de doublons, qui nécessitent un nettoyage ultérieur.

Ce processus est pénible, raison pour laquelle l'orchestration des flux de données est devenue un élément clé des stacks de données modernes. Elle représente un processus automatisé qui contrôle les pipelines de données, créant ainsi une harmonie dans le mouvement des données. L'orchestrateur permet d'écrire, de planifier et de surveiller le pipeline de données. La gestion manuelle des pipelines de données ne favorise pas une mise à l'échelle efficace. Le développement de scripts Python pour chaque étape du processus est susceptible d'entraîner de nombreux problèmes. L'orchestration des données facilite la gestion des incidents de pipeline, des échecs de connexion, l'exécution en chaîne et le maintien de l'ordre.

Airflow : Un outil d'orchestration puissant

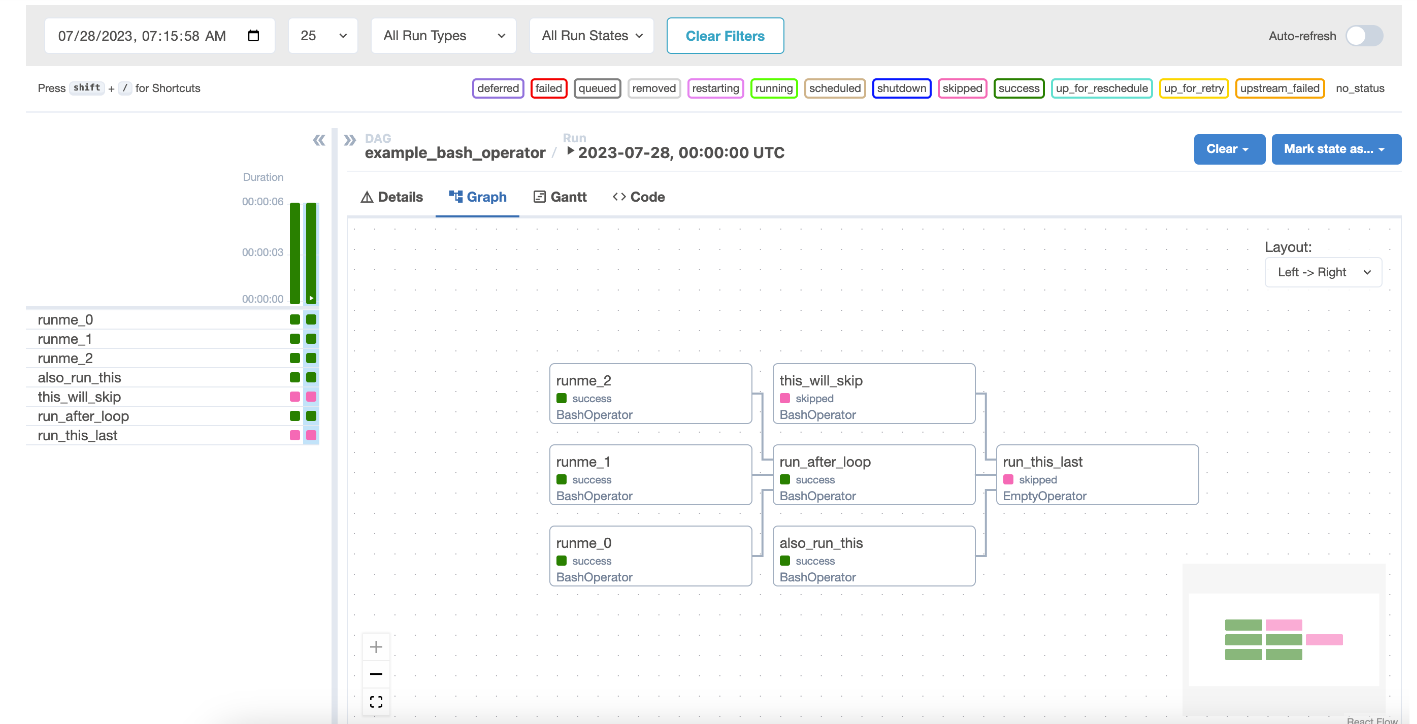

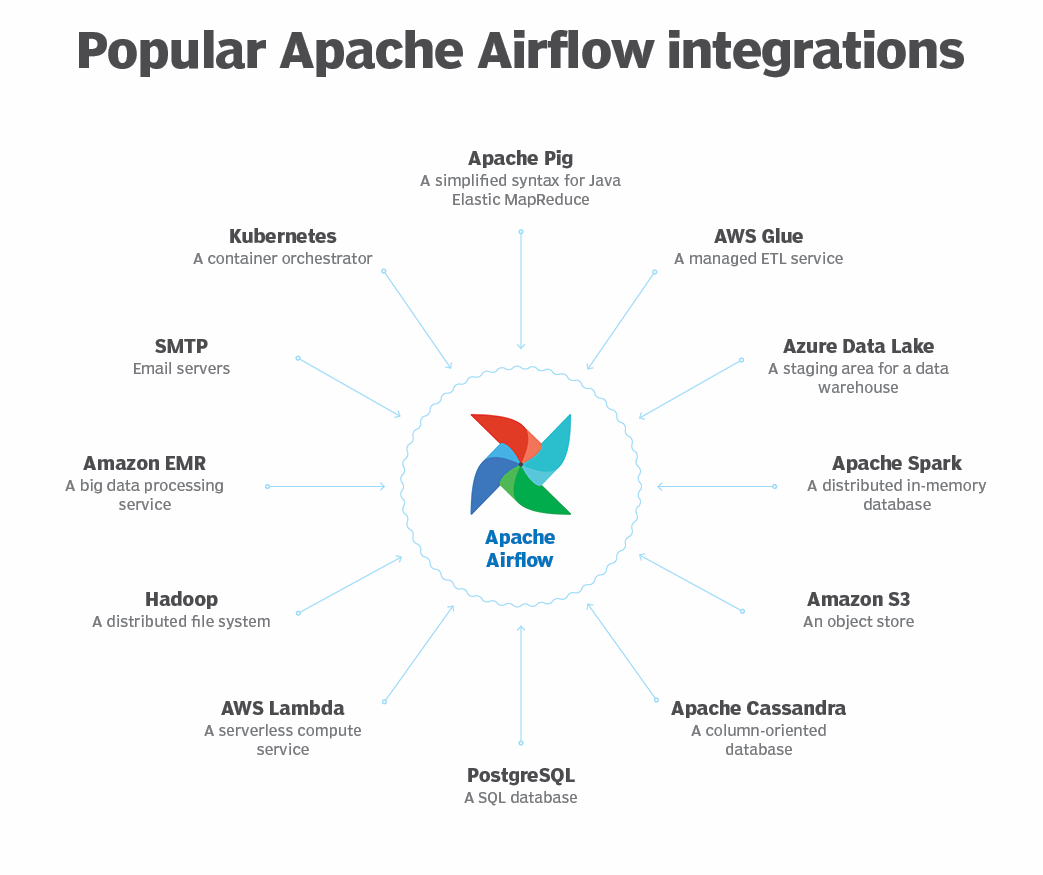

Airflow est une plateforme open source conçue pour orchestrer des workflows de données, en permettant de créer, planifier et surveiller séquentiellement ou en parallèle une série de tâches selon certaines conditions ou dépendances, dans le but d'atteindre un objectif commun tel que le traitement, l'analyse ou la visualisation des données. Utilisant le langage Python pour définir les workflows, Airflow offre une grande souplesse et simplicité de développement. Il intègre également une interface web utile pour gérer le statut des workflows, consultez les logs, ou encore déclencher des exécutions manuelles. Grâce à son support pour de nombreux opérateurs, Airflow se connecte aisément à une variété de technologies, y compris les bases de données et les systèmes de fichiers, augmentant ainsi sa polyvalence.

Comprendre les outils individuels : Airflow, PostgreSQL et MongoDB

Explorons les capacités uniques d'Airflow, PostgreSQL, et MongoDB avant d'aborder leur intégration. Chacun de ces outils offre des avantages spécifiques essentiels à connaître.

Airflow est conçu pour orchestrer des workflows de données. Ces workflows, ou flux de travail, sont des séquences d'opérations effectuées sur des données dans le but d'atteindre un objectif spécifique. Ces opérations peuvent inclure l'extraction, la transformation, le chargement de données, et l'analyse pour produire des rapports. En utilisant Python pour décrire ces workflows, Airflow accorde une flexibilité remarquable et simplifie la maintenance. Son interface utilisateur web facilite la visualisation et le contrôle des workflows, tandis qu'une API offre la possibilité d'interagir avec eux depuis d'autres applications.

PostgreSQL est un système de gestion de bases de données relationnelles qui excelle dans la gestion de données structurées en tables. Il intègre des fonctionnalités avancées comme les transactions, types de données complexes, fonctions, déclencheurs (triggers), vues, index, et extensions. Conforme aux standards SQL, PostgreSQL simplifie grandement les requêtes et la manipulation des données. Sa réputation s’appuie sur sa fiabilité, robustesse, excellente performance et niveau élevé de sécurité.

MongoDB, de son côté, est un système de gestion de bases de données, idéal pour manipuler des données semi-structurées sous forme de documents. Ces derniers, qui emboîtent des paires clé-valeur similaires au format JSON, offrent une flexibilité considérable pour la définition et la modification de la structure des données. Avec des capacités supérieures de gestion de données en temps réel et adapté au big data, MongoDB se distingue par sa performance, la facilité avec laquelle il peut se distribuer sur plusieurs machines (sharding), et sa capacité de réplication garantissant une disponibilité continue.

Le besoin d'une combinaison technologique

Explorons pourquoi l'alliance d'Airflow, PostgreSQL et MongoDB est avantageuse, et en quoi elle se distingue des autres options. Nous aborderons cette question à travers trois aspects fondamentaux : l'orchestration et la gestion des données, la performance et l'évolutivité, ainsi que la fiabilité et la sécurité.

Orchestration et gestion des données

Le data engineering et data science font face au défi de la complexité et de la variété des sources de données. Il est essentiel de pouvoir extraire, transformer, et charger (ETL) les données de multiples systèmes, comme des API, des fichiers et des bases de données. Or, orchestrer et surveiller ces processus de manière automatisée et cohérente est tout aussi crucial.

Airflow relève ce défi en offrant une plateforme qui facilite la création, la programmation, et le suivi des workflows de données. Il vous permet de définir vos workflows avec Python, offrant une flexibilité pour manipuler vos données selon vos besoins. Vous pouvez aussi bien utiliser des opérateurs prédéfinis que personnalisés pour interagir avec divers systèmes, tels que PostgreSQL et MongoDB, rendant ainsi la gestion de vos données à la fois efficiente et souple.

Performance et évolutivité

Un autre enjeu majeur du data engineering et de la science des données est le traitement de volumes de données en augmentation, à la fois variés et de grande taille. Il est crucial d'avoir la capacité de stocker et d'analyser des données structurées et semi-structurées, en temps réel ou en différé, en garantissant une performance élevée et une faible latence.

PostgreSQL et MongoDB répondent à cette nécessité en proposant des systèmes de gestion de base de données à la fois performants et évolutifs. PostgreSQL excelle dans le stockage et la gestion de données structurées sous forme de tables, offrant des fonctionnalités avancées et une compatibilité étendue avec les normes SQL. MongoDB, quant à lui, se spécialise dans le traitement de données semi-structurées en documents, promettant une grande flexibilité et un rendement élevé pour les données au format JSON. Capables de se déployer sur plusieurs machines (sharding) et de se répliquer pour assurer leur disponibilité (replication), PostgreSQL et MongoDB vous fournissent les outils pour gérer de grands volumes de données avec une efficacité et une élasticité optimales.

Fiabilité et sécurité

Assurer la fiabilité et la sécurité des données représente un autre défi essentiel pour le data engineering et la data science. Il est fondamental de maintenir la qualité, la cohérence et l'intégrité des données, et de les protéger contre les pertes, corruptions ou accès non autorisés.

Airflow, PostgreSQL et MongoDB répondent à ces exigences en proposant des systèmes éprouvés et sécurisés. Airflow surveille l'état de vos workflows de données, permettant la détection et la correction d'erreurs ou d'anomalies. PostgreSQL et MongoDB contribuent à la cohérence et à l'intégrité des données avec des mécanismes tels que transactions, types de données complexes, fonctions, et triggers. Ensemble, ils assurent la protection de vos données via l'authentification, le chiffrement et le contrôle d'accès. Airflow, PostgreSQL et MongoDB sont donc synonymes de fiabilité et de sécurité pour vos données.

Intégration d'Airflow avec PostgreSQL et MongoDB

Cette section vous expliquera comment configurer Airflow pour permettre les connexions à PostgreSQL et MongoDB. Vous allez également découvrir comment orchestrer des tâches utilisant ces deux bases de données. Les intégrations avec Apache Airflow

Airflow fonctionne avec des commandes bash, ainsi qu’avec un large éventail d’autres outils. Par exemple, certaines des intégrations d’Airflow incluent Kubernetes, AWS Lambda, PostgreSQL et d'autres comme ceux de l'image ci-dessous.

Configurer Airflow avec PostgreSQL

Pour une intégration réussie d'Airflow avec PostgreSQL, suivez ces étapes :

- Installez le package apache-airflow-providers-postgres. Ce package inclut tout ce dont vous avez besoin pour interagir avec PostgreSQL : opérateurs, hooks et capteurs.

- Créez une connexion via l'interface utilisateur d'Airflow ou en ligne de commande, en spécifiant les paramètres requis tels que conn_id, host, schema, login et password. Assurez-vous de sélectionner Postgres comme type de connexion.

- Testez la connexion avec la commande airflow connections test postgres votre_conn_id.

Configurer Airflow avec MongoDB

Pour connecter Airflow à MongoDB, suivez ces étapes :

- Installez le package apache-airflow-providers-mongo, qui fournit les opérateurs, hooks et capteurs nécessaires à l'interaction avec MongoDB.

- Établissez une connexion en précisant les paramètres requis comme conn_id, host, schema, login et password, en utilisant soit l'interface utilisateur d'Airflow, soit la ligne de commande. Choisissez MongoDB comme type de connexion.

- Utilisez la commande airflow connections test mongo votre_conn_id pour vérifier que tout fonctionne correctement.

Exécution de tâches d'orchestration avec Airflow utilisant PostgreSQL et MongoDB

Après avoir configuré les connexions nécessaires, vous êtes prêt à orchestrer des tâches impliquant PostgreSQL et MongoDB. Vous pouvez par exemple créer un workflow qui extrait des données de PostgreSQL, les transforme et les charge dans MongoDB. Les packages apache-airflow-providers-postgres et apache-airflow-providers-mongo offrent les outils nécessaires pour cela. Voici un exemple de code :

Utilisation avancée de la combinaison technologique : Airflow, PostgreSQL et MongoDB

Dans cet article, nous explorons comment combiner efficacement Airflow, PostgreSQL et MongoDB pour mener à bien des opérations sophistiquées dans les domaines du data engineering et de la data science. Nous aborderons trois thèmes principaux : l'automatisation de processus via Airflow, la manipulation avancée des données grâce à PostgreSQL et MongoDB, et enfin, les méthodes de surveillance et de dépannage.

Dans cette section, nous explorerons l'exploitation des fonctionnalités avancées des technologies Airflow, PostgreSQL, et MongoDB. Ces outils, utilisés conjointement, facilitent des opérations complexes comme le machine learning, le big data, et l'implémentation d'un modern data stack

Automatisation des tâches avec Airflow

Airflow facilite l'automatisation des processus liés aux données en permettant la création de workflows programmables, selon un calendrier précis ou en réponse à certains déclencheurs. Cela aide à organiser et exécuter vos opérations de manière efficace et systématique. Imaginez un workflow programmé pour récupérer des données depuis une API, les traiter avec du code Python, les enregistrer dans PostgreSQL ou MongoDB, et finalement les analyser à l'aide de MongoDB Charts. Il est également possible de développer des workflows intégrant des opérations de machine learning, de traitement de grandes quantités de données ou du stack technologique moderne. Airflow offre donc la possibilité d'atteindre un haut niveau d'automatisation dans la gestion de vos tâches de données..

Machine learning

Le machine learning, une branche de l'intelligence artificielle, se focalise sur le développement de modèles capables d'apprendre de données pour effectuer des tâches complexes telles que classification, régression, détection d'anomalies et recommandations. Cette démarche nécessite des données de qualité, leur préparation, entraînement, évaluation, et déploiement.

La combinaison Airflow, PostgreSQL, et MongoDB optimise ces processus, offrant une automatisation efficace. Airflow orchestre le flux de travail des données à travers les diverses étapes du cycle de vie du machine learning. PostgreSQL gère les données et modèles structurés, tandis que MongoDB s'occupe des données semi-structurées, incluant les analyses et prédictions.

Big data

Le terme big data sera utilisé ici pour décrire des ensembles de données caractérisés par de grands volumes, diversité et rapidité de traitement. Dans le monde du data engineering et data science, cela représente à la fois un défi et une opportunité, nécessitant des solutions pour stocker, traiter et analyser de vastes quantités de données diversifiées efficacement.

Avec Airflow, PostgreSQL, et MongoDB, relever ces défis devient plus aisé. Airflow permet l'orchestration de flux de données à grande échelle. PostgreSQL offre un stockage et une gestion optimisés des données structurées, tandis que MongoDB excelle dans la gestion des documents semi-structurés avec performance. Ces systèmes facilitent également le sharding et la réplication pour une haute disponibilité.

Modern data stack

Le modern data stack se compose d'outils et technologies adaptés à la création de solutions en data engineering et data science qui sont à la fois modernes, performantes et évolutives. Ce concept s'appuie sur l'extraction, le chargement, la transformation, et l'analyse des données (ELT).

Airflow, PostgreSQL, et MongoDB constituent des éléments clés du modern data stack. Airflow s'occupe de l'extraction et du chargement des données vers PostgreSQL ou MongoDB. Ces derniers, en tant que systèmes de gestion de base de données, assurent un stockage et une gestion performante. Enfin, à travers des outils d'analyse comme Tableau, Looker, Metabase, etc., il est possible de se connecter à ces bases de données pour visualiser et explorer les données.

Exemples d'utilisation de la combinaison Airflow, PostgreSQL et MongoDB

Nous explorons les bénéfices de la synergie entre Airflow, PostgreSQL et MongoDB à travers deux cas d'étude concrets, démontrant l'efficacité de cette combinaison dans les domaines du data engineering et de la data science.

Cas n° 1 : Optimisation de la chaîne d'approvisionnement dans l'industrie manufacturière

Contexte :

Une entreprise manufacturière cherche à améliorer l'efficacité de sa chaîne d'approvisionnement. Elle doit traiter et analyser des volumes importants de données sur les fournisseurs, les coûts, les délais de production et les tendances du marché pour optimiser les stocks et les cycles de production.

Pipeline ETL avec Airflow, PostgreSQL et MongoDB :

- Extraction :

- Airflow orchestre des tâches quotidiennes pour extraire les données des systèmes ERP (Enterprise Resource Planning), des plateformes SCM (Supply Chain Management) et des bases de données des fournisseurs.

- Les données comprennent les commandes de matières premières, les niveaux d'inventaire, les temps de cycle de production et les données de livraison.

- Transformation :

- Les données brutes sont stockées dans PostgreSQL où elles sont normalisées et préparées pour l'analyse. Les transformations incluent la conversion des devises, la standardisation des unités de mesure et la consolidation des données de multiples fournisseurs.

- Les données historiques sont utilisées pour calculer les tendances et les prévisions, en utilisant des modèles statistiques et des algorithmes de prévision.

- Chargement :

- Les données transformées sont ensuite chargées dans MongoDB, qui sert de système de stockage pour les données opérationnelles et analytiques.

- MongoDB est idéal pour ce cas d'usage en raison de sa flexibilité dans le stockage de documents et sa capacité à gérer efficacement les données hétérogènes et en constante évolution de la chaîne d'approvisionnement.

- Analyse et Optimisation :

- Les données dans MongoDB sont utilisées pour alimenter des applications d'analyse avancée et des tableaux de bord qui aident à identifier les goulots d'étranglement dans la chaîne d'approvisionnement et à prévoir les besoins en matières premières.

- Les insights générés permettent d'optimiser les niveaux de stock, de réduire les coûts, d'améliorer les délais de livraison et de répondre plus efficacement à la demande fluctuante.

Avantages de cette approche :

- Réactivité : La capacité d'Airflow à exécuter des workflows planifiés garantit que les données les plus récentes sont toujours disponibles pour la prise de décision.

- Précision : PostgreSQL gère les données transactionnelles avec une grande précision, assurant l'intégrité des données pour les analyses.

- Flexibilité : MongoDB offre la possibilité de stocker et d'interroger rapidement des données non structurées ou semi-structurées, ce qui est fréquent dans les opérations de la chaîne d'approvisionnement.

- Optimisation : L'intégration de ces technologies permet une analyse en temps réel de la chaîne d'approvisionnement, facilitant une réponse rapide aux changements du marché et aux imprévus.

Cas n° 2 : Amélioration de la qualité et du suivi de production

Contexte :

Un constructeur automobile souhaite optimiser son processus de contrôle qualité et de suivi de production en temps réel. La chaîne de montage génère une quantité considérable de données, allant des paramètres des machines à l'inspection de la qualité des véhicules en fin de chaîne. Analyser ces données permet d'identifier rapidement les défaillances potentielles et d'améliorer l'efficience de la production.

Pipeline ETL avec Airflow, PostgreSQL et MongoDB :

- Extraction :

- Airflow orchestre l'extraction des données issues de divers capteurs et systèmes sur la chaîne de montage, incluant des données sur les performances des machines, les taux de défauts, les retours qualité et les résultats des tests de sécurité.

- Ces données sont extraites des systèmes IoT (Internet des Objets) et des bases de données opérationnelles.

- Transformation :

- Les données sont stockées temporairement dans PostgreSQL où elles subissent un nettoyage, une transformation et une agrégation. Cela peut inclure la correction d'erreurs, l'harmonisation des formats de date/heure et la combinaison de données provenant de différentes sources pour créer une vue unifiée.

- Les algorithmes de détection d'anomalies et les modèles statistiques sont appliqués pour identifier les tendances et les déviations.

- Chargement :

- Les données traitées sont ensuite chargées dans MongoDB, qui est utilisé pour sa flexibilité et sa capacité à gérer de grands volumes de données non structurées rapidement et de manière performante.

- MongoDB peut héberger des tableaux de bord opérationnels permettant le suivi en temps réel des paramètres de production et des alertes de qualité.

- Analyse et Action :

- Les données dans MongoDB alimentent des systèmes d'analyse avancée qui aident à diagnostiquer les causes profondes des défaillances et à identifier les opportunités d'amélioration continue.

- Les insights extraits sont utilisés pour ajuster les paramètres de production en temps réel, pour planifier la maintenance préventive et pour améliorer les conceptions des véhicules.

Avantages de cette approche :

- Proactivité : La combinaison d'Airflow, PostgreSQL et MongoDB permet d'anticiper les problèmes avant qu'ils ne se manifestent sur la ligne de production.

- Qualité : Le suivi précis des données de production contribue à une amélioration constante de la qualité des véhicules.

- Efficience : L'analyse en temps réel optimise l'efficience opérationnelle, réduit les temps d'arrêt et améliore la productivité.

- Adaptabilité : La flexibilité du système permet d'adapter rapidement la production aux nouvelles exigences ou aux retours des inspections de qualité.

Conclusion

Cet article a mis en avant une solution technologique performante pour répondre à vos exigences en data, associant Airflow, PostgreSQL et MongoDB. Nous avons décrit comment intégrer ces outils pour élaborer des pipelines de données à la fois efficaces et évolutifs. Il est cependant important de souligner que la pertinence de ce combo technologique dépend fortement de la cartographie et de l'architecture existante de chaque client. L'intégration d'Airflow, bien que puissante, doit être mise en perspective avec les services déjà en place, comme ceux proposés par Azure, et nécessite une évaluation approfondie des coûts, des objectifs de l'entreprise et des contraintes opérationnelles. La comparaison avec d'autres solutions possibles est cruciale pour définir l'option qui répondra au mieux à vos objectifs spécifiques. C'est par l'écoute et l'audit de votre architecture actuelle que nous pouvons apporter un conseil avisé sur les possibilités d'intégration et d'amélioration.

Si cette solution a retenu votre attention, nous vous encourageons à consulter leur documentation officielle, qui offre un aperçu complet de leurs capacités et possibilités. Vous découvrirez comment cette solution peut contribuer au succès de vos projets de données, garantissant qualité, performance et évolutivité.

Au sein de nos équipes, nous développons l'infrastructure nécessaire pour traiter les données des clients à grande échelle. Notre approche est fondée sur l'adaptabilité et la personnalisation, et c'est dans l'écoute et l'audit de l'architecture de nos clients que nous pouvons proposer des solutions sur mesure, répondant précisément à vos enjeux et objectifs.

Si l'association de ces technologies éveille votre intérêt , discutons ensemble !

Ressources Agaetis